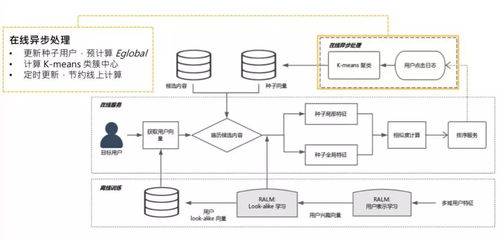

微信看一看中的灰盒Look-alike策略实践 计算系统架构与算法应用(下篇)

在上一篇文章中,我们探讨了灰盒Look-alike策略在微信看一看中的核心逻辑与策略价值。本篇将聚焦于实现这一策略所需的计算机软硬件开发及应用,揭示其背后的技术架构与工程实践。

一、硬件基础设施:弹性计算与分布式存储

微信看一看的灰盒Look-alike策略依赖于强大的硬件支持。计算集群采用混合部署模式,结合CPU与GPU异构计算资源。GPU集群主要用于模型训练阶段的矩阵运算加速,而CPU集群则承担在线推理与实时特征处理任务。存储层面,采用分布式文件系统(如HDFS)与列式数据库(如ClickHouse)的组合,前者存储原始日志与模型参数,后者支持用户画像特征的高效查询与更新。

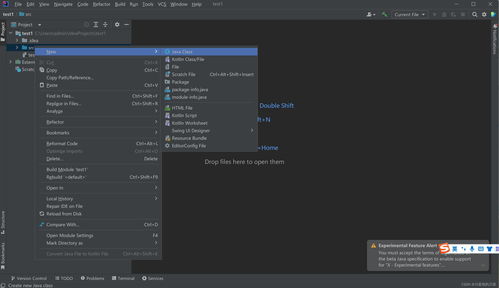

二、软件系统架构:微服务与流批一体

软件层面,系统采用微服务架构,将策略拆分为特征工程、模型服务、流量分配等独立模块。特征工程服务负责实时处理用户行为序列,通过Flink流式计算框架实现秒级特征更新;模型服务则基于TensorFlow Serving或自研推理引擎,提供低延迟的相似度计算。流批一体设计确保了离线训练与在线服务的数据一致性,例如使用Apache Kafka作为消息队列,同步用户实时交互数据至训练样本池。

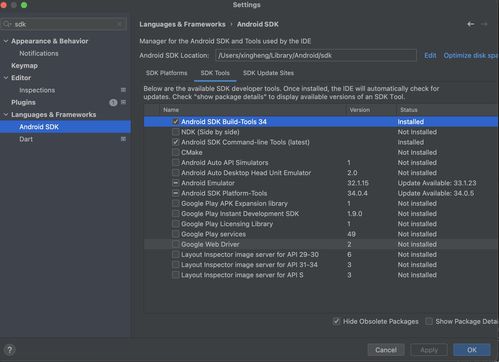

三、算法工程化:自适应学习与冷启动优化

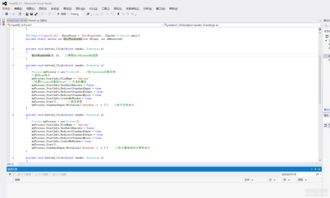

灰盒Look-alike的核心算法需兼顾效率与效果。工程实现中,模型采用双塔结构:一塔编码种子用户(已知兴趣群体),另一塔编码候选用户。为应对微信海量用户规模,工程团队引入了局部敏感哈希(LSH)等技术压缩向量检索空间。针对冷启动问题,系统融合了用户基础属性(如地域、设备)与协同过滤信号,在行为数据稀疏时提供保底推荐。在线学习机制允许模型根据实时反馈动态调整权重,例如通过Bandit算法探索小众兴趣群体。

四、性能监控与迭代闭环

策略落地离不开持续监控与迭代。系统部署了多层指标仪表盘:硬件层面监控GPU利用率与缓存命中率;算法层面跟踪相似度分布的基尼系数与覆盖率;业务层面则关注点击率、留存率等核心指标。AB测试平台支持策略快速验证,每次模型更新均通过分层抽样实验对比效果。反馈数据自动回流至训练管道,形成“数据-模型-服务”的闭环优化体系。

五、挑战与展望

当前系统仍面临诸多挑战:如何在保护用户隐私的前提下利用跨场景数据?如何平衡Look-alike的“相似性”与信息茧房风险?团队计划探索联邦学习实现跨平台安全建模,并引入因果推断技术突破相关性局限。硬件上,正测试AI芯片与存算一体架构,以进一步降低推理成本。

微信看一看的灰盒Look-alike策略是算法创新与工程实践深度融合的典范。它不仅体现了策略产品从逻辑设计到系统落地的完整路径,更展现了在超大规模场景下,通过软硬件协同进化持续提升用户体验的技术生命力。

如若转载,请注明出处:http://www.kmled168.com/product/55.html

更新时间:2026-02-25 12:13:26